微信号

15618884964

据4月23日消息,一份百度文心一言技术团队内部会议纪要流出。从纪要内容中看,在文心一言启动邀测后一个多月期间,似乎用户同时在线数的高速增长对文心一言的响应速度提出了挑战,也对百度内部一直强调的人工智能四层框架“芯片层-框架层-模型层-应用层”中,模型层和框架层的联合优化协同有了更高要求。

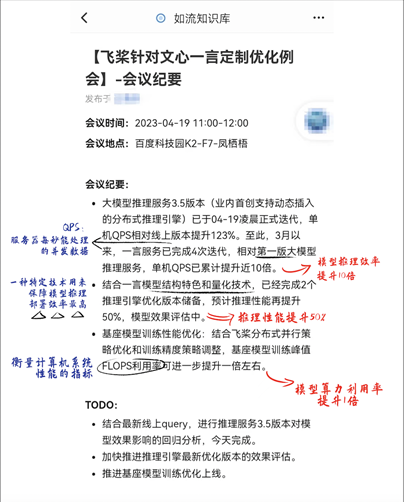

从纪要日期中看,内部飞桨技术团队从发布开始截止至4月19日,35天里对于一言服务已完成4次迭代,最新已迭代至大模型推理服务3.5版本,平均保持着一星期左右完成1次迭代的速率。

关键数据一:单机QPS相对线上版本提升高达123%,模型推理效率提升10倍

“大模型推理服务3.5版本(业内首创支持动态插入的分布式推理引擎)已于04-19凌晨正式迭代,单机QPS相对线上版本提升123%。至此,3月以来,一言服务己完成4次迭代,相对第一版大模型推理服务,单机QPS已累计提升近10倍。“

从去年ChatGPT引爆全球生成式AI的浪潮后,国内千行百业纷纷积极拥抱新浪潮,但对于企业来讲,“生成式AI+原业态”相结合的应用创新还处于早期阶段,并未有成熟模式可直接迁移使用,因此长期的创新成本投入会使得众多企业望而却步。

而此次百度大模型推理服务3.5版本的QPS大幅提升,模型推理效率提升10倍。这将意味着模型推理成本降低为原来的1/10,或可为10倍数量的用户提供服务,这一关键数据向市场释放了大模型技术将更加普惠的信号,意味着大模型在各行业落地的成本将大幅降低,有望加速国内大模型的产业化进程,使得大模型技术“飞入寻常百姓家”。

QPS即表示服务器一秒内可以处理的并发数量,有分析人士解读认为,“大模型就仿佛汽车的发动机,光账面上的动力强,参数大是没有用的,要压榨出发动机瞬时最大爆发力(QPS)以及最优的性能表现。”

关键数据二:模型推理性能提升50%

“结合一言模型结构特色和量化技术,已经完成2个推理引擎优化版本储备,预计推理性能再提升50%,模型效果评估中。”

目前对于全球大部分头部公司来讲,均需要基于TensorFlow和PyTorch等深度学习框架进行再开发,无法直接满足大模型训练需求。而百度文心一言及背后的大模型,均以自研的产业级深度学习框架飞浆做支撑,此次模型推理性能的提升,也证明自研深度学习框架飞浆对于文心一言快速学习能力的支撑作用功不可没。分析人士解读认为, “仍以汽车发动机举例,深度学习框架就像是生产发动机和变速箱的,可以让发动机整体部件组合更精密、动力更强。而百度全栈自研产品彼此适配度更高,协同会更高效,这可能是效率提升的最根本原因。”

关键数据三:模型算力利用率提升一倍

“基座模型训练性能优化:结合飞桨分布式并行策略优化和训练精度策略调整,基座模型训练峰值FLOPS利用率可进一步提升一倍左右。”

数据、算法、算力作为人工智能三要素,虽然截止至2020年,芯片计算算性能已经提升了600倍,但随着数据井喷,模型算力仍是行业需要共同面对挑战。而此次基于飞桨分布式并行策略优化和训练精度策略调整,将模型算力利用率提升一倍,可以说是百度人工智能四层架构实现端到端优化、形成反馈闭环的最佳体现。

随着3月16日百度作为全球大厂中第一个发布类ChatGPT的生成式AI产品文心一言后,4月开始,商汤、阿里、华为、腾讯等互联网大厂、头部AI公司相继进行大模型发布,生成式AI正式进入“诸神之战”,但发布只是第一步,率先实现技术、场景落地与成本的完美平衡,或许才是国内大模型未来的最佳实践路径。

微信号

15618884964